AP: Falešné fotky a videa z války v Gaze zvyšují obavy ze schopností AI

03.12.2023 , Aktualizováno 30.11.2023

Mezi záběry rozbombardovaných domů a zpustošených ulic Pásma Gazy vynikaly některé naprostou hrůzou: zkrvavená a opuštěná nemluvňata. Tyto snímky, které byly od začátku války na internetu zobrazeny milionkrát, jsou podvrhy vytvořené pomocí umělé inteligence (AI). Pokud se podíváte pozorně, můžete si všimnout vodítek: podivně zkroucených prstů nebo očí, které se lesknou nepřirozeným světlem, to vše jsou poznávací znamení digitálního podvodu. Rozhořčení, které měly fotografie vyvolat, je však až příliš reálné, napsala agentura AP.

Foto: Shutterstock

Snímky z války mezi Izraelem a Hamásem názorně a bolestně ukázaly potenciál umělé inteligence jako nástroje propagandy, který se používá k vytváření realistických obrazů krveprolití.

„Bude hůř, mnohem hůř, než bude líp,“ řekl Jean-Claude Goldenstein, generální ředitel technologické společnosti CREOpoint se sídlem v San Francisku a Paříži, která využívá umělou inteligenci k ověřování tvrzení na internetu. „Obrázky, videa a zvuky: s generativní AI to bude eskalace, jakou jste ještě neviděli,“ dodal.

V některých případech byly fotografie z jiných konfliktů nebo katastrof znovu použity a vydávány za nové. V jiných byly programy generativní umělé inteligence použity k vytvoření snímků od základu nebo ke zhotovení videí ukazujících údajné izraelské raketové údery, tanky projíždějící zničenými čtvrtěmi nebo rodiny, které v sutinách hledají přeživší.

V mnoha případech se zdá, že tyto podvrhy mají vyvolat silnou emocionální reakci tím, že obsahují kojence, děti nebo rodiny.

Propagandisté, kteří takové snímky vytvářejí, jsou vycvičení cíleně působit na nejhlubší pudy a obavy lidí, uvedl Imran Ahmed, generální ředitel Centra pro potírání digitální nenávisti (CCDH), neziskové organizace, která sleduje dezinformace z války. Ať už se jedná o deepfake dítěte, nebo o skutečný obrázek kojence z jiného konfliktu, emocionální dopad na diváka je stejný.

Čím je obrázek odpornější, tím je pravděpodobnější, že si ho uživatel zapamatuje a bude ho sdílet, čímž nevědomky šíří dezinformaci dál.

Podobně klamavý obsah generovaný pomocí umělé inteligence se začal šířit po ruské invazi na Ukrajinu v roce 2022. Jedno pozměněné video vypadalo, že ukazuje ukrajinského prezidenta Volodymyra Zelenského, jak nařizuje Ukrajincům, aby se vzdali. Taková tvrzení se šířila naposledy ještě minulý týden, což ukazuje, jak vytrvalé mohou být i snadno vyvratitelné dezinformace.

Každý nový konflikt nebo volební období poskytuje šiřitelům dezinformací nové příležitosti k demonstraci nejnovějších pokroků umělé inteligence. To nutí mnoho odborníků na AI a politologů varovat před riziky v příštím roce, kdy se v několika zemích konají významné volby, včetně USA, Indie, Pákistánu, Ukrajiny, Tchaj-wanu, Indonésie a Mexika.

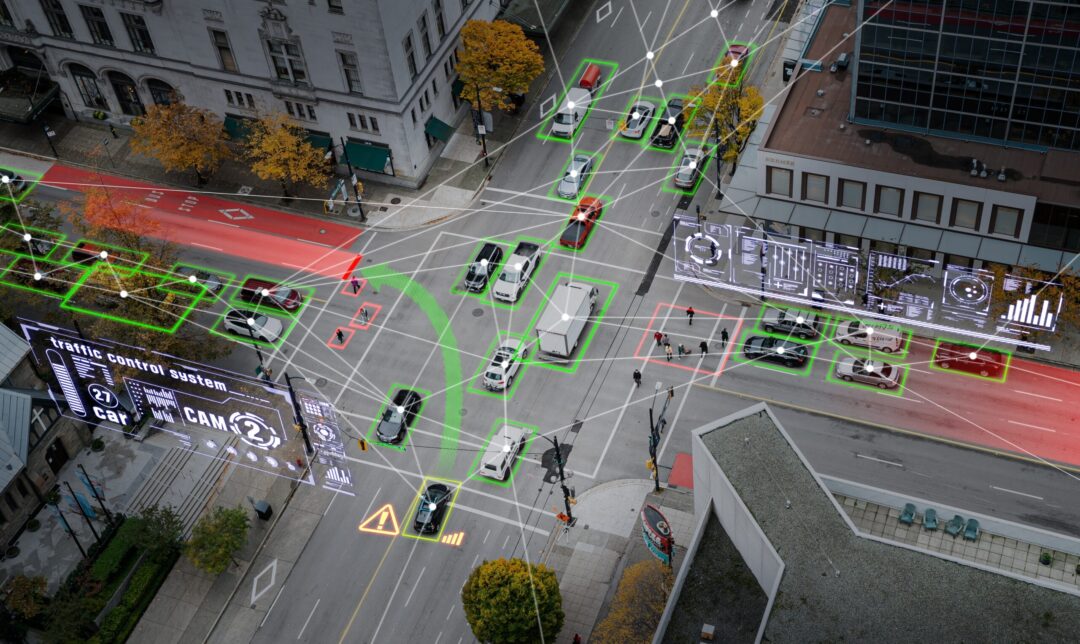

Po celém světě pracuje řada začínajících technologických firem na nových programech, které dokážou rozpoznat deepfakes, připojit vodoznaky k obrázkům, aby prokázaly jejich původ, nebo skenovat text, aby ověřily případná nepravdivá tvrzení, která mohla být vložena umělou inteligencí.

„Další vlna umělé inteligence bude: Jak můžeme ověřit obsah, který je tam venku. Jak lze odhalit dezinformace, jak analyzovat text, abychom zjistili, zda je důvěryhodný?“ řekla Maria Amelieová, spoluzakladatelka norské společnosti Factiverse. Ta vytvořila program AI, jenž dokáže skenovat obsah a hledat v něm nepřesnosti nebo zkreslení vnesené jinými programy umělé inteligence.

Takové programy by byly bezprostředně zajímavé pro pedagogy, novináře, finanční analytiky a další zájemce o vyvracení nepravd, plagiátů nebo podvodů. Podobné programy jsou vyvíjeny také k odhalování zfalšovaných fotografií nebo videí.

Podle Davida Doermanna, počítačového vědce, který vedl snahu výzkumné agentury amerického ministerstva obrany DARPA reagovat na hrozby pro národní bezpečnost, jež představují obrázky zmanipulované umělou inteligencí, je tato technologie slibná. Ti, kdo AI využívají ke lhaní, jsou ale podle něj často o krok napřed.

Doermann, který nyní působí jako profesor na univerzitě v Buffalu, uvedl, že účinná reakce na politické a společenské výzvy, které dezinformace umělé inteligence představují, bude vyžadovat lepší technologie, lepší předpisy, dobrovolné průmyslové standardy a rozsáhlé investice do programů digitální gramotnosti, které pomohou uživatelům internetu zjistit, jak rozlišit pravdu od fantazie.

Tel Aviv/Gaza (ČTK/AP)